Ranken in Google begint bij het optimaliseren van de techniek achter je website.

Door je website met technische SEO te optimaliseren zorg je ervoor dat de Google-bots jouw content eenvoudig kunnen vinden en indexeren. Dit is de eerste stap voor zoekmachine optimalisatie, zodat je in de zoekresultaten van Google kunt verschijnen.

In deze gids leggen we uit wat technische SEO precies is, waarom het zo belangrijk is voor zoekmachine optimalisatie en hoe je de technische aspecten kunt optimaliseren. Aan het einde vind je een interactieve checklist om direct zelf aan de slag te gaan.

Wat is technische SEO?

Technische SEO is het gedeelte van Search Engine Optimization (zoekmachine optimalisatie) waarmee je de techniek achter je website verbetert. Technische zoekmachine optimalisatie helpt zoekmachines zoals Google om de pagina’s van jouw website beter te vinden, crawlen, begrijpen en indexeren.

Waarom is technische SEO belangrijk?

Technische SEO moet eigenlijk het startpunt zijn van iedere SEO strategie. De techniek achter SEO zorgt ervoor dat zoekmachines jouw content eenvoudig kunnen vinden en indexeren.

Je kunt zoveel goede content schrijven als je wil en dit volledig optimaliseren met on-page SEO. Als de technische kant van jouw website niet op orde is, zal de content niet gevonden worden. Hierdoor kun je dus niet ranken in Google.

Door technische SEO goed toe te passen ben je beter vindbaar, blijf je je concurrentie voor en kun je hoger ranken. Lees verder over de voor- en nadelen van SEO om meer te weten te komen over het belang van zoekmachineoptimalisatie. Of bekijk wat het kost om een SEO-specialist in te huren om technische SEO uit te besteden.

Hoe werken zoekmachines?

Om het belang van technische SEO beter toe te lichten moet je weten hoe zoekmachines werken. Zoekmachines, zoals Google, werken met drie primaire systemen:

Crawlen. Het vinden van nieuwe URL’s

Indexen. Het toevoegen van URL’s aan de database

Ranken. Het tonen van URL’s in de zoekresultaten

Met behulp van deze systemen kan Google de gebruiker helpen om te vinden waar ze naar op zoek zijn. Google weet namelijk precies welke URL’s er online zijn, welke content ze bevatten en of ze relevant zijn voor bepaalde zoekopdrachten.

Technische SEO zorgt ervoor dat jouw website eenvoudig gecrawld kan worden. Google kan de pagina’s hierdoor opnemen in hun index. Een pagina wordt vervolgens in de zoekresultaten weergegeven (ranken) als deze overeenkomt met een bepaalde zoekterm.

Wat is crawling?

Dagelijks worden er duizenden nieuwe webpagina’s gepubliceerd. Het is aan de zoekmachines om deze te vinden door te crawlen. Je kunt het zien als kleine robotspinnetjes die vanuit bestaande pagina’s op zoek gaan naar nieuwe pagina’s.

De crawlers volgen links die op pagina’s worden toegevoegd. Zo ontdekken ze steeds nieuwe webpagina’s die vervolgens geïndexeerd kunnen worden.

Het doel van crawling is om zoveel mogelijk pagina’s te ontdekken. Hoe meer pagina’s er beschikbaar zijn, hoe beter Google kan afwegen welke pagina’s de beste informatie geeft. Deze pagina zal kans maken om hoog te ranken.

Crawling door Google

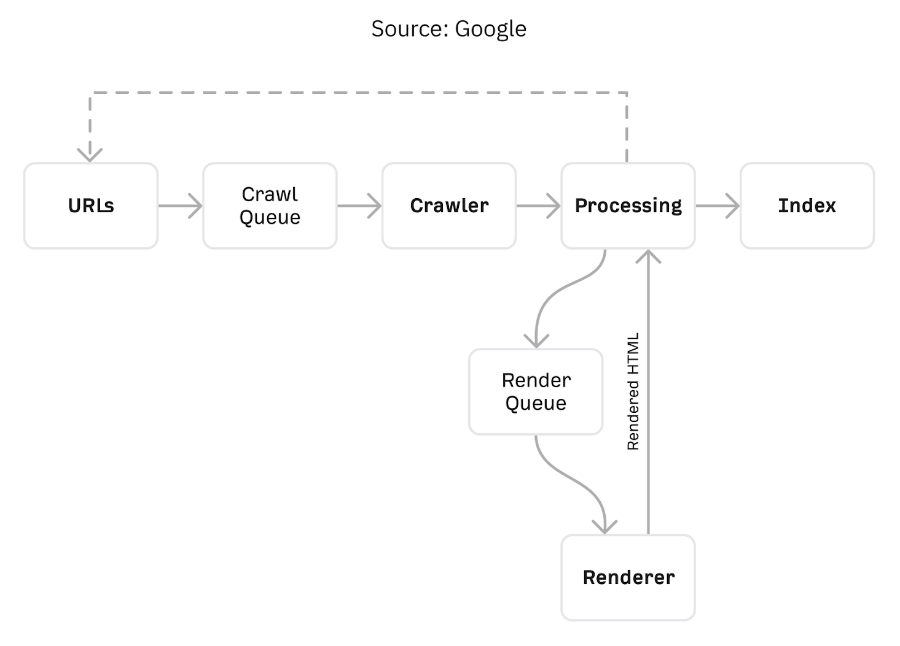

Het proces dat Google gebruikt om pagina’s te crawlen kan omschreven worden in zes stappen:

Bron URL. Een crawler moet ergens beginnen. De bron URL wordt vaak bepaald aan de hand van een pagina die eerder is gecrawld of vanuit een xml-sitemap.

Crawl wachtrij. De verschillende URL’s die moeten worden gecrawld krijgen een prioriteit en komen in een wachtrij te staan.

Crawlen. Een voor een worden de URL’s uit de wachtrij gecrawld. Een URL crawlen is het proces waarbij de robots de content op de pagina scannen.

Verwerking gegevens. Er zijn systemen die canonicalization (dubbele content) afhandelen, systemen die de pagina naar de renderer sturen en systemen die URL’s, die ze op de pagina tegenkomen, toevoegen aan de crawl wachtrij.

Renderer. Het renderer systeem laadt pagina’s zoals in een browser. Een zoekmachine ziet op deze manier wat een websitegebruiker ziet. Net als met crawlen komen de pagina’s die gerenderd moeten worden eerst in een wachtrij te staan.

Indexering. Een pagina die zowel gecrawld als gerenderd is, wordt toegevoegd aan Google’s index. De index van Google is een enorm grote database met alle pagina’s die Google via het crawling proces heeft gevonden en zo heeft kunnen indexeren.

Het is belangrijk om te weten dat een pagina alleen kan ranken wanneer deze is geïndexeerd door de zoekmachine. Een pagina die een crawler blokt of problemen oplevert tijdens het renderen kan niet worden geïndexeerd en dus niet ranken.

Met behulp van technische SEO zorg je ervoor dat de pagina’s op je website probleemloos geïndexeerd kunnen worden.

Crawl-budget

Een crawler die op een van jouw pagina’s terecht komt, zal niet je hele website crawlen. Per keer wordt slechts een beperkt aantal URL’s gecrawld. Dit wordt het crawl-budget genoemd.

Met technische SEO kun je ervoor zorgen dat Google de juiste URL’s crawlt en geen tijd verspilt aan oninteressante webpagina’s. Je kunt er ook voor zorgen dat het crawlproces wordt versneld, waardoor er meer URL’s gecrawld kunnen worden.

Wat is indexing?

Google’s definitie voor indexeren: “Een pagina wordt geïndexeerd door Google als de pagina is bezocht door de Google-crawler (Googlebot), is geanalyseerd op content en betekenis en is opgeslagen in de Google-index.”

Indexeren is dus het proces waarbij Google gecrawlde pagina’s opslaat in hun index. Alleen URL’s die in deze index staan kunnen worden weergegeven in de zoekresultaten.

Het doel van indexeren is om zoveel mogelijk pagina’s in de database op te slaan. Deze pagina’s kunnen worden vergeleken voor een zoekopdracht. Google kan er zo voor zorgen dat de meest relevante pagina bovenaan in de zoekresultaten verschijnt.

Robots

De robots staan aan het begin van het indexeringsproces. Zij crawlen verschillende URL’s om te bepalen of een URL uniek is en welke content de pagina bevat.

De reactie van een robot op een URL wordt in eerste instantie bepaalt door het robots.txt bestand. In dit bestand staat aangegeven welke delen van je website wel en niet mogen worden gecrawld of geïndexeerd.

Er zijn drie mogelijke uitkomsten wanneer een crawler wel of niet op het robots.txt bestand stuit:

De Googlebot kan geen bestand vinden en crawlt iedere pagina op de website.

De Googlebot vindt het robots.txt bestand en zal zich doorgaans aan de suggesties houden bij het crawlen van de website.

De Googlebot kan het bestand niet openen en dus niet bepalen of er een bestaat of niet. De site wordt niet gecrawld.

Het in orde maken en uploaden van een robots.txt bestand is een onderdeel van technische SEO. Met behulp van dit txt bestand kun je ervoor zorgen dat jouw website op de juiste manier wordt geïndexeerd.

Canonicalization

Canonicalization vindt plaats als er bijna identieke websitepagina’s op één website aanwezig zijn. Pagina’s die dezelfde invulling hebben kunnen negatieve invloed hebben op de rankings van je website.

Je kunt er het beste voor zorgen dat je zo min mogelijk dubbele content op je website hebt. In sommige gevallen kun je er echter niet omheen.

Dubbele pagina’s komen bijvoorbeeld vaak voor op webshops. Denk maar eens aan het filteren van een product op maat of kleur. Alle content blijft hetzelfde, alleen de details van het product veranderen.

Met behulp van technische SEO zorg je ervoor dat Google jouw dubbele pagina’s goed interpreteert.

Canonicalization is het proces waarbij Google slechts één pagina indexeert als de crawlers verschillende versies tegenkomen. Door Google te helpen met het bepalen welke pagina geïndexeerd moet worden kunnen je rankings een boost krijgen.

Verbeter de technische SEO van je website

Tot nu toe hebben we het vooral gehad over crawlen en indexeren. Het is belangrijk om deze processen op orde te hebben, zodat Google de juiste webpagina’s kan vinden.

Technische SEO houdt echter veel meer in. Denk maar eens aan de organisatie, structuur en laadtijd van je website. Met behulp van een volledige website analyse kun je de volgende punten aan het licht brengen.

Site structuur en navigatie

Structuur en navigatie op een website vormen het uitgangspunt van technische SEO. Als deze aspecten niet op orde zijn kunnen crawlers je site niet vinden of niet goed indexeren.

De sitestructuur wordt opgemaakt door verschillende factoren, zoals het menu, breadcrumbs en de interne linkstructuur. Het beïnvloed vrijwel alle andere optimalisaties die je op de website uitvoert. Het is dus belangrijk om dit eerst in orde te hebben, om de rest een stuk eenvoudiger te maken.

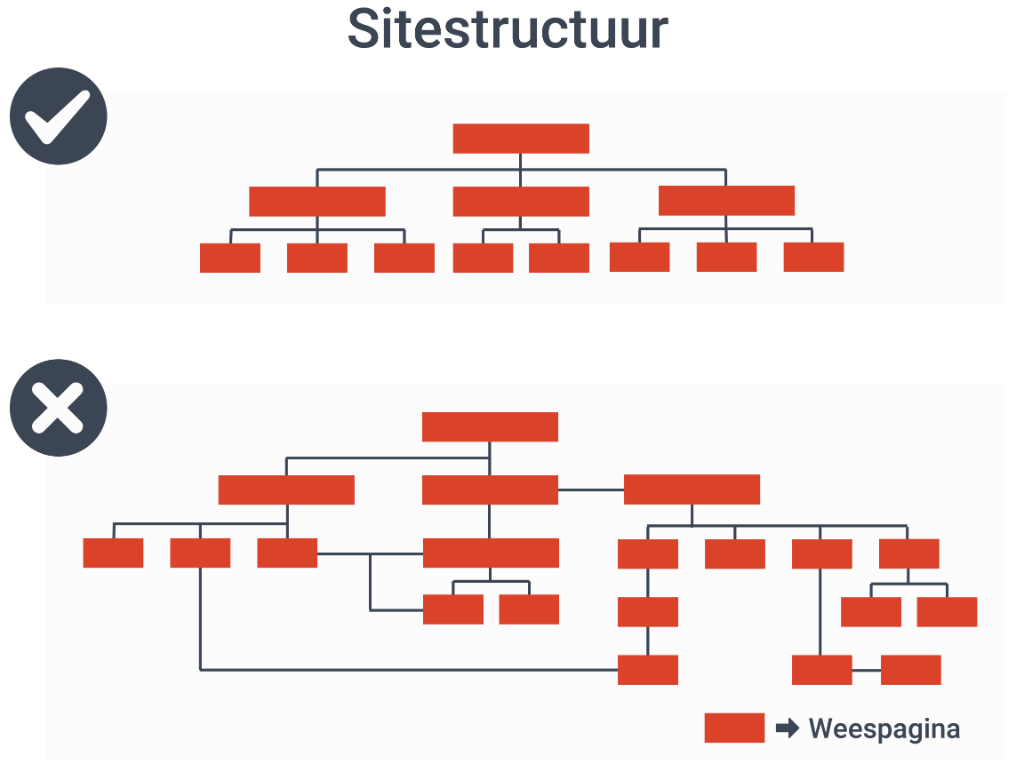

Als uitgangspunt kun je stellen dat je een platte sitestructuur moet hebben. Dit wil zeggen dat alle pagina’s op je site slechts enkele klikken bij elkaar vandaan zijn. Google en andere zoekmachines kunnen zo eenvoudig 100% van jouw pagina’s crawlen.

In een complexe site structuur komen vaak ‘weespagina’s’ voor. Weespagina’s hebben geen interne links die naar het artikel verwijzen. Crawlers kunnen deze pagina’s vrijwel niet vinden.

Breadcrumbs

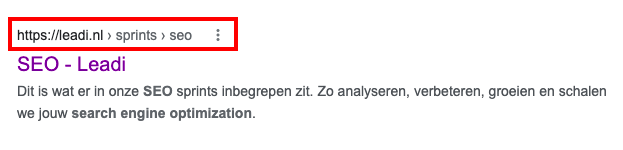

Breadcrumbs zijn links die bovenaan een pagina staan om navigatie super eenvoudig te maken. Een breadcrumb laat zien via welke categorie of subpagina je op de URL terecht komt.

Naast goede navigatie helpen deze links ook om je sitestructuur duidelijk te maken. Google laat nu zelfs de breadcrumbs zien in de zoekresultaten.

Zeker wanneer jouw sitestructuur meerdere lagen diep gaat, zijn breadcrumbs een enorme toevoeging voor SEO.

Breadcrumbs geven crawlers gelijk een indicatie van de structuur van je website. Zo maak je het makkelijk voor bots om je site te interpreteren.

Internal linking

Crawlers volgen links die ze tegenkomen op pagina’s. Een goede interne linkstructuur helpt crawlers dus om meerdere pagina’s op jouw website te crawlen.

Een artikel zonder interne links is een dood einde en een artikel waar geen interne links naar toe verwijzen zal niet gevonden worden.

Interne links vanuit pagina’s met een hoge autoriteit hebben meer waarde. Deze pagina’s worden vaker gecrawld. De kans is hierdoor groter dat een artikel/post/pagina vanuit die autoritaire pagina gevonden wordt door de crawler.

Link diepte

De link diepte geeft aan hoeveel lagen er zijn vanaf de homepagina. Met een platte en overzichtelijk site structuur zal de diepte maximaal 4 tot 5 links diep zijn.

Een minder diepe interne linkstructuur zorgt ervoor dat pagina’s beter vindbaar zijn. Het zijn namelijk vaak de artikelen die onderaan de sitestructuur hangen waar weinig naar gelinkt wordt. Deze pagina’s zijn voor crawlers dus moeilijk om te vinden.

Indexering & Crawling

Het voornaamste doel van technische SEO is om een site eenvoudig crawlbaar en indexeerbaar te maken. Om deze processen te optimaliseren moet je weten welke pagina’s problemen opleveren. Dit kun je doen met behulp van verschillende tools:

Google Search Console

Screaming Frog & Deepcrawl

Ahrefs & SEMrush

Hieronder zullen we verder uitleggen hoe deze technische SEO software je kunnen helpen om je site eenvoudiger te crawlen en beter indexeerbaar te maken.

Google Search Console

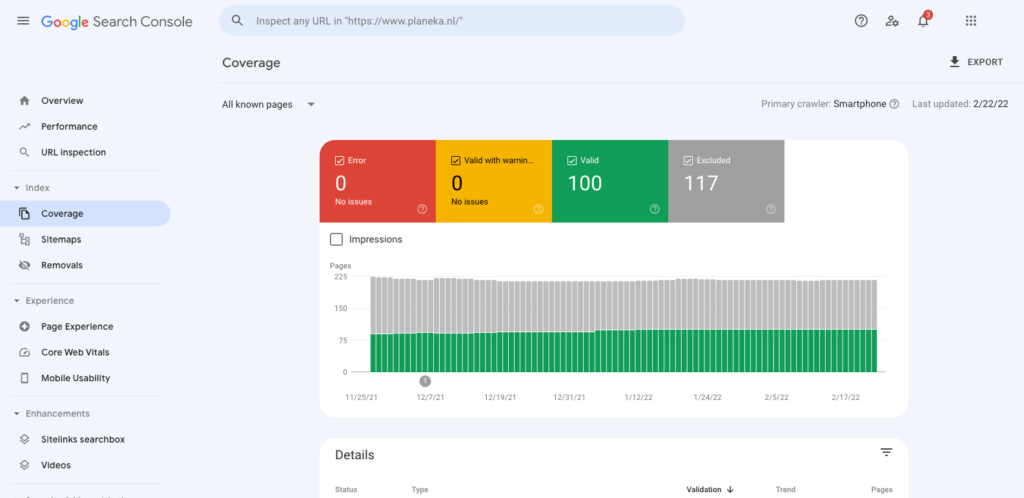

Google Search Console is een gratis technische SEO-tool waar je eenvoudig een coverage report uit kunt halen. Dit is een overzicht van de pagina’s die Google niet kan bereiken of kan indexeren.

Om dit rapport op te vragen klik je in het menu aan de linkerkant op ‘coverage’ onder het kopje ‘index’.

In de details van het rapport zie je of er eventuele problemen zijn. Door op een probleem te klikken zie je welke URL’s problemen geven. Met deze informatie kun je de pagina’s verbeteren. Na het optimaliseren van pagina’s kun je opnieuw indexering aanvragen.

Je kunt ook zien of belangrijke pagina’s ontbreken in de index of dat bepaalde pagina’s ten onrechte zijn geïndexeerd. Aan de hand hiervan kun je optimalisaties uitvoeren.

Het is belangrijk om controle te hebben over wat er in de Google index terecht komt. De Googlebot weet op deze manier ook beter hoe jouw webinhoud gecrawld moet worden.

Stel de tool direct zelf in met behulp van onze handige gids.

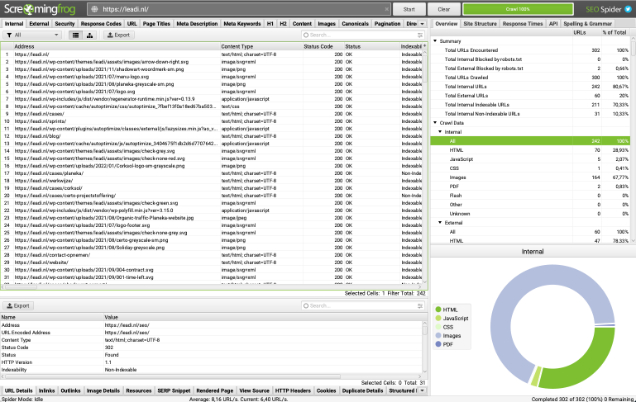

Screaming Frog en Deepcrawl

Zowel Screaming Frog als Deepcrawl zijn crawlers die je kunt inzetten om je volledige website te laten crawlen. Hieruit kunnen technische SEO-problemen naar voren komen die je vervolgens kunt oplossen.

Enkele punten waar deze crawlers op letten zijn:

Gebroken links. Deze links worden ook wel dode links genoemd. Het is een link, maar ze leiden naar een 404 pagina, dus een pagina die niet bestaat.

Meta tags. De crawlers vertellen je of je te korte of te lange titels en meta descriptions gebruikt. Pagina’s die een meta tag missen komen ook naar voren.

Rendering. Je pagina’s worden gerenderd om te controleren of zich problemen voordoen met de HTML/CSS/JavaScript.

Redirects. Pagina’s die doorverwijzen naar een andere URL kunnen vertragingen opleveren. Je kunt beter direct naar de eind-URL linken.

Duplicate content. De crawlers ontdekken duplicate content, zoals dubbele pagina’s, dubbele elementen, dubbele paginatitels enz.

Blokkades. Je krijgt inzicht in URL’s die zijn geblokkeerd door robots.txt bestanden of tags zoals ‘no-index’ of ‘no-follow’ of ‘canonical’.

Site structuur. Beide tools bieden een optie om de sitestructuur in kaart te brengen en zo ‘weespagina’s te ontdekken.

De tools kunnen zelfs suggesties geven voor interne links en andere optimalisaties.

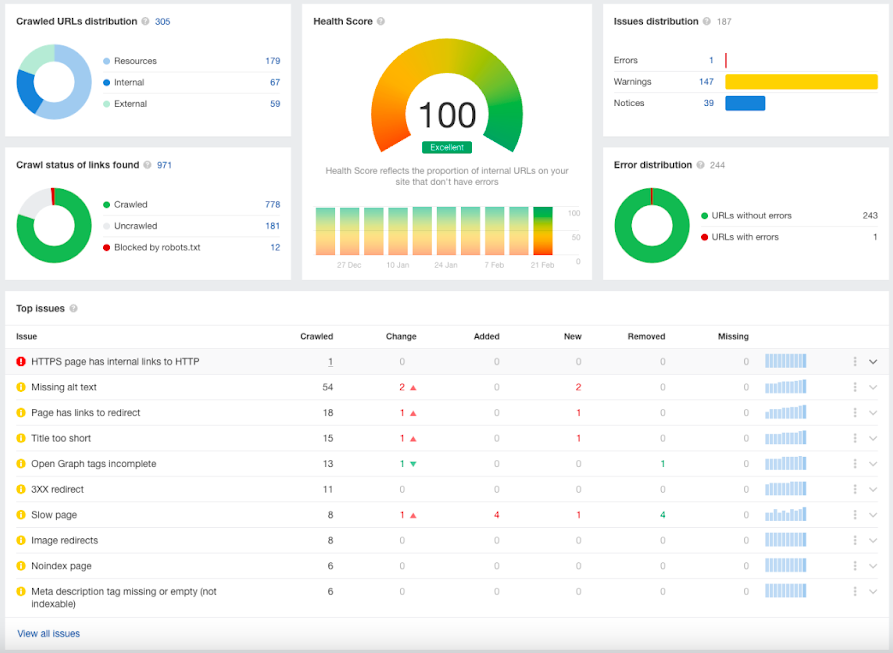

Ahrefs en SEMrush site audits

Ahrefs en SEMrush zijn beide complete SEO-tools waarmee je alle aspecten van SEO op jouw site kunt controleren.

Als het aankomt op technische SEO kun je met deze tools inzicht krijgen in de volgende punten:

Hoeveel URL’s er gecrawld zijn

Hoe diep jouw websitestructuur is

Wat de laadtijd van een pagina is

Pagina’s die een meta tag missen of een te korte/te lange meta tag hebben

XML-Sitemaps

Een XML-sitemap is een soort inhoudsopgave van je website. Waar een HTML-sitemap beter leesbaar is voor ons, is een XML-sitemap beter leesbaar voor crawlers. Het maakt het makkelijker voor crawlers om je website te indexeren, omdat er een volledige lijst van URL’s beschikbaar is.

In een XML-sitemap zijn ook een aantal meta gegevens beschikbaar, zoals:

Wanneer de pagina voor het laatst aangepast is. Aan de hand hiervan kan een crawler bepalen of de pagina opnieuw geïndexeerd moet worden of niet.

Hoe vaak de pagina bijgewerkt is. Belangrijke pagina’s worden vaker gewijzigd dan andere pagina’s. Hierdoor kan Google bepalen welke pagina’s belangrijker zijn.

Hoe belangrijk een pagina is. No-index pagina’s worden niet in een XML-sitemap opgenomen. Als je dubbele content hebt, zet dan alleen de canonical URL in de XML-sitemap.

Je kunt in Google Search Console controleren welke XML-sitemap Google op dit moment van jouw website heeft. Ga hiervoor in het linker menu naar ‘Sitemaps’ onder het kopje ‘Index’.

Scroll door de XML-sitemap heen om in te zien of er pagina’s ontbreken of juist pagina’s instaan die niet geïndexeerd hoeven te worden.

Er zijn verschillende technische SEO-tools beschikbaar om een XML-sitemap te creëren. XML-sitemaps.com biedt bijvoorbeeld de mogelijkheid om een gratis XML-sitemap te maken voor websites met minder dan 500 URL’s.

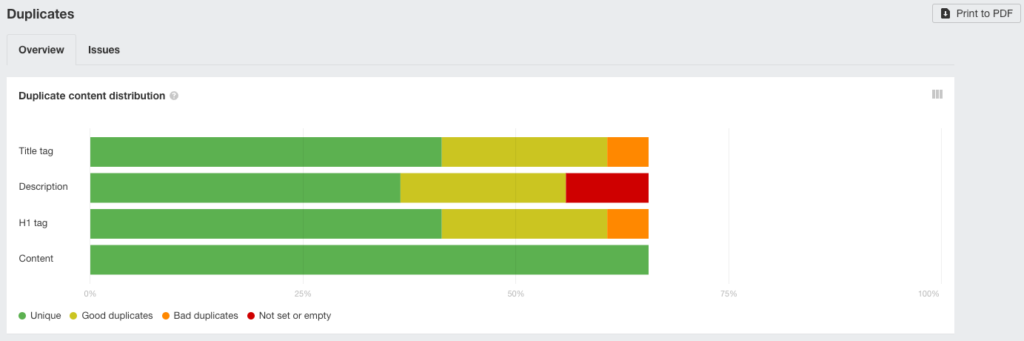

Duplicate content

Als het gaat om duplicate content, met andere woorden dubbele content, kan dit op twee verschillende manieren opgevat worden, namelijk:

Content die je meerdere keren op je eigen website gebruikt

Content die niet alleen op jouw website, maar ook op andere websites voorkomt

Dubbele content, in welke zin dan ook, kan een negatieve invloed hebben op je rankings. Het is dus belangrijk om te weten of je dubbele content hebt en als dit zo is hoe je hiermee om moet gaan.

Duplicate content op je eigen website

Ahrefs geeft een overzicht van eventuele dubbele content in de ‘Content Quality’ sectie. Ze controleren of je meta tags, titels, snippets of andere content meerdere keren gebruikt op je site.

Dubbele content op je eigen website kun je updaten, zodat de overeenkomsten vervallen. Soms kom je er echter niet onderuit om dubbele content te gebruiken.

Om ervoor te zorgen dat je niet wordt afgestraft voor deze dubbele content moet je Google slechts een van de pagina’s met dubbele content laten indexeren.

Door het toepassen van de volgende tags kun je met technische SEO het indexeren van een URL tegenhouden:

Robots.txt tag. Kan worden gebruikt om bepaalde pagina’s af te schermen van zoekmachines. De crawlers kunnen deze pagina niet bereiken.

No index tag. De crawler kan een pagina wel bereiken, maar zal deze niet indexeren.

No follow tag. Met de no follow tag zorg je ervoor dat een crawler een link op jouw website niet volgt om te crawlen.

Canonical tag. Met de canonical tag vertel je Google dat er dubbele pagina’s zijn, maar dat de crawlers alleen de hoofdpagina moeten indexeren. De waarde van de andere pagina’s wordt toegekend aan de geïndexeerde pagina.

Duplicate content op andere websites

CopyScape is een technische SEO-tool die controleert of de content op jouw website ook op andere websites wordt gebruikt.

Dubbele content die overeenkomt met een andere website kan twee dingen betekenen:

Een andere website heeft jou gekopieerd

Jij hebt een andere website gekopieerd

In het eerste geval hoef je geen actie te ondernemen, want Google ziet jou als de originele bron. In het tweede geval kun je maar beter je content bijwerken om penalty’s te voorkomen.

Je kunt controleren wie de originele bron is door de duplicate content tussen “dubbele aanhalingstekens” in Google in te voeren. De website die als eerste wordt weergegeven is de originele bron.

Thin content

Thin content, of met andere woorden magere content, verwijst naar pagina’s met een klein aantal woorden.

Deze pagina’s kunnen je rankings op negatieve manier beïnvloeden. Google hecht namelijk waarde aan informatieve content die de lezer daadwerkelijk informeert over een onderwerp.

Een pagina met minder dan 300 woorden wordt over het algemeen als mager beschouwd. Je kunt deze pagina’s het beste een no-index tag geven, zodat ze niet geïndexeerd worden. Op deze manier hebben ze geen invloed op je rankings.

Block robots

Het robots.txt bestand van je website kan je helpen om Google te laten weten welke pagina’s wel en niet gecrawld mogen worden.

Je kunt crawlers dus blokkeren op bepaalde pagina’s. Door de Googlebots tegen te houden kunnen ze de URL niet crawlen, renderen en indexeren. De pagina wordt hierdoor als niet bestaand beschouwd en heeft op geen enkele manier invloed op je rankings.

Een belangrijk onderdeel van technische SEO is om dit bestand up-to-date te houden. Zo kun je crawlers weghouden van duplicate content.

Canonical tags

In sommige gevallen wil je dubbele content op je website gebruiken. Bijvoorbeeld in het geval van een webshop waarbij producten in meerdere kleuren of maten beschikbaar zijn.

Je kunt met een canonical tag aangeven welke pagina Google moet indexeren.

De pagina’s die bij de hoofdpagina horen worden niet geïndexeerd. Eventuele waarde van de andere pagina’s wordt toegekend aan de hoofdpagina.

Hreflang tags

Hreflang is een onderdeel van technische SEO dat wordt toegepast op websites die beschikbaar zijn in meerdere talen. Met behulp van Hreflang geef je aan de crawler door welke pagina’s gelijkwaardig zijn aan elkaar.

Een Hreflang-tag vertelt Google welke taal je op een specifieke pagina gebruikt. De zoekmachine kan dit resultaat weergeven aan gebruikers die in deze taal zoeken.

Aan de hand van de locatie van een gebruiker weet Google in welke taal de pagina weergegeven moet worden.

Een website die in het Nederlands en Engels beschikbaar is zal Google onderverdelen. De website wordt automatisch in het Engels geopend voor een gebruiker in het Verenigd Koninkrijk en in het Nederlands voor een gebruiker in Nederland.

Pagina snelheid

Een ander belangrijk aspect van technische SEO is de snelheid van je website. Er wordt hierbij gekeken naar verschillende punten, zoals:

Hoe lang het duurt voor de eerste pixel laadt

Hoe lang het duurt voordat de eerste interactie plaats kan vinden

Hoe lang het duurt voordat een actie wordt uitgevoerd

De laadtijd wordt van iedere pagina apart bepaald. Door de snelheid van je pagina’s te optimaliseren bereik je een betere gebruikservaring. Dit telt voor een groot deel mee in je Google score om te kunnen ranken.

Core Web Vitals

De core web vitals van Google zijn punten aan de hand waarvan ze de gebruikservaring van een website meten. Door deze punten met behulp van technische SEO te optimaliseren, maak je de techniek van jouw website in orde.

Onderstaande punten worden gemeten met behulp van de core web vitals:

LCP. Dit staat voor Largest Contentful Paint en geeft aan wanneer de eerste bruikbare content op de pagina laadt.

FID. Dit staat voor First Input Delay en geeft aan hoe lang het duurt om een actie, zoals scrollen of klikken, uit te voeren.

CLS. Dit staat voor Cumulative Layout Swift en geeft aan of bepaalde acties moeilijk zijn om uit te voeren door verschuivingen op de pagina.

SSL

Een SSL-certificaat maakt een website veiliger. Je kunt een veilige website herkennen doordat deze begint met https in plaats van http.

Met zo’n certificaat wordt de gegevensuitwisseling beveiligd. Informatie die wordt uitgewisseld tussen de website en de bezoeker kan niet door een derde partij onderschept worden.

Het SSL-certificaat biedt dus zowel veiligheid voor jou als de website-eigenaar als voor de gebruiker:

Het houdt de inhoud van een website veilig

Het houdt de gegevens die gebruikers op de website invoeren veilig

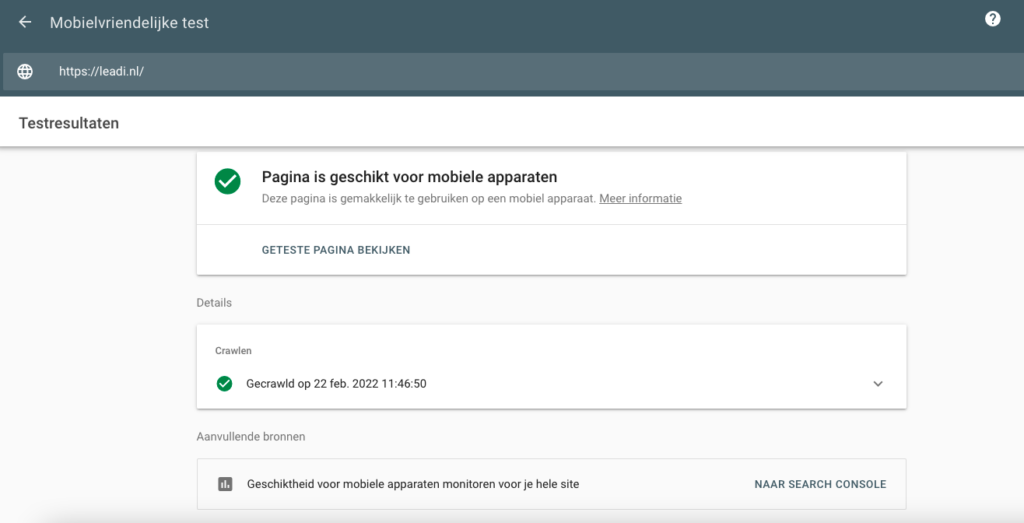

Mobile-first indexing

Steeds meer gebruikers bezoeken het internet via hun mobiele telefoon. In de afgelopen jaren heeft er een flinke verschuiving plaats gevonden. Waar 10 jaar geleden de meeste sites nog via een desktop werden bezocht, heeft inmiddels mobiel gebruik de overhand.

Google indexeert pagina’s dan ook volgens hun mobile-first principes. Ze kijken dus eerst hoe snel en toegankelijk een mobiele pagina is en hoe de gebruikservaring is.

Een geoptimaliseerde website voor mobiel gebruik kan dus niet meer ontbreken. Gelukkig heeft Google een eigen tool ontwikkelt om de mobielvriendelijkheid te testen.

Na het uitvoeren van de test wordt aangegeven op welke technische SEO-punten je de mobiele website nog kunt verbeteren. Ga hiermee aan de slag om ervoor te zorgen dat de mobiele versie van jouw site in orde is.

Afbeeldingen

Afbeeldingen kunnen een pagina ontzettend traag maken. Afbeeldingen met een groot bestandsformaat hebben een langere laadtijd.

Je kunt afbeeldingen op verschillende manieren optimaliseren om de laadtijd van de pagina te verbeteren, zoals:

Afbeeldingen verkleinen, zodat de laadtijd sneller wordt en de grootte van de pagina zelf zo klein mogelijk blijft.

Stel ‘Lazy Load’ in, zodat afbeeldingen pas laden als ze in beeld verschijnen. Dit zorgt ervoor dat de laadtijd sneller is, omdat er niet gewacht hoeft te worden tot alle afbeeldingen vooraf geladen zijn.

URL-structuur

De URL-structuur moet overzichtelijk zijn. Een URL moet de gebruiker namelijk laten zien waar hij of zij zich op de site bevindt.

Op deze website bevind je je nu bijvoorbeeld in het blog gedeelte. Dit kun je in de URL zien aan de hand van /blog/.

Wil je meer informatie over de sprints van Leadi, dan kom je /sprints/ tegen in de URL. Hetzelfde geldt voor /werkwijze/ in de URL van het gedeelte van de website waar we je uitleggen hoe wij te werk gaan.

Als je een uitgebreide blog hebt, kun je ervoor kiezen om categorieën op te nemen in je URL-structuur. Iedere pagina in deze categorie geeft via de URL een beetje extra informatie over het onderwerp door aan Google.

Het belangrijkste is om je sitestructuur consistent te houden. Gebruik daarbij zo kort mogelijke URL’s en gebruik geen onnodige voeg- of bijwoorden.

Goede URL-structuur:

https://leadi.nl/blog/technische-seo

Onoverzichtelijke URL-structuur: https://leadi.nl/blog/seo/techniek/optimaliseren/technische-seo-als-basis-voor-online-vindbaarheid

HTML, CSS en JavaScript

Als je zelf met een website aan de slag bent gegaan zul je deze termen vast wel eens zijn tegengekomen. Het zijn codes waarmee jouw website tot stand komt.

Zelfs wanneer je gebruik maakt van een page builder op een WordPress website, zullen deze codes aan de achterkant een grote rol spelen.

Het is vanuit een technisch oogpunt belangrijk dat je deze codes op orde hebt. Google is namelijk minder goed in het renderen van complexe structuren.

Er bestaat een kans dat Google de gebruikservaring van jouw website niet goed kan beoordelen als de codes niet op orde zijn. Je kunt je website dus het beste zo simpel mogelijk houden.

Om beter te begrijpen waar je op kunt letten als het aankomt op technische SEO zetten we hieronder op een rijtje wat de verschillende codes doen:

HTML. De HTML-codes zorgen voor de sitestructuur. Denk aan het weergeven van titels, tussenkopjes, titels, normale tekst etc. Je kunt er het beste voor zorgen dat je belangrijkste navigatiefuncties in deze taal geschreven zijn.

CSS. De CSS-codes zorgen ervoor dat alles er mooi uitziet. Denk aan kleuren, lettertypes en het algemene uiterlijk van je website.

JavaScript. Met behulp van JavaScript kun je interactieve elementen aan je pagina toevoegen. Teveel JavaScript kan voor rendering problemen zorgen. Google kan hierdoor geen compleet beeld krijgen van je pagina’s.

Met behulp van Screaming Frog kun je een crawling rapport opvragen. Aan de hand hiervan kun je eventuele crawling en rendering problemen inzien en aanpakken.

Dead links

Dead links zijn links die leiden naar 404-pagina’s. Links die eindigen op een 404-pagina bestaan niet en een crawler loopt daar dus dood.

Volgens Google is het absoluut geen probleem voor technische SEO als je dead links hebt naar externe pagina’s. Voor interne links is dit echter een ander verhaal.

Een gebroken interne link maakt het namelijk moeilijker voor een Googlebot om jouw website te crawlen. Indexeren kan hierdoor een probleem zijn, wat weer kan leiden tot een pagina die niet kan ranken.

Dus hoewel Google aangeeft dat gebroken links niet direct leiden tot lagere rankings, kan het zeker gevolgen hebben. Doe eens in de zoveel tijd een dead link audit om zeker te weten dat al je interne links nog werken.

Je kunt eenvoudig controleren of je gebroken links hebt met behulp van alle eerdergenoemde indexering en crawling tools.

Structured data

Structured data helpt crawlers om de informatie op jouw website op de goede manier te interpreteren. Met behulp van structured data kun je bijvoorbeeld aangeven of jouw pagina een recept, how-to, review of product omschrijft.

Door structured data op jouw website toe te passen kun je in de snippets van Google terecht komen. Deze snippets worden vaak boven de organische zoekresultaten weergegeven. Op deze manier kan structured data een enorme boost op organisch verkeer opleveren.

In ons artikel Rank bovenaan Google met structured data lees hoe je dit aspect op jouw website kunt verbeteren.

Benieuwd of onze werkwijze jou kan helpen?

Plan een gratis gesprek in om er samen achter te komen.

Technische SEO-tools

Technische SEO is een groot onderdeel van het optimaliseren van je website. Gelukkig zijn er een aantal tools beschikbaar om een technische SEO analyse uit te voeren. Zo kun je bepalen wat er precies geoptimaliseerd moet worden.

Google Search Console

Google Search Console kun je gratis opzetten en is bereikbaar via de webbrowser. Je kunt met deze tool inzicht krijgen hoe je website presteert in de zoekresultaten van Google.

Via deze tool kun je ook problemen met een crawlen, indexeren en mobiel gebruik achterhalen.

Google Search Console biedt ook tools om je off-page SEO te optimaliseren. Zo kun je bijvoorbeeld inzicht krijgen in je backlinks.

Je kunt rapporten uitdraaien en real-time meldingen ontvangen als Google problemen heeft met je website. Het is dus een hele krachtige tool om je SEO te optimaliseren en bij te houden.

Mobile-Friendly Test

De mobile-friendly test hebben we eerder in dit artikel al laten vallen. Het is een technische SEO-tool van Google die jou kan helpen om de gebruikservaring van je mobiele pagina’s in te zien. Ze geven indien nodig ook advies om pagina’s voor mobiel gebruik te verbeteren.

Core Web Vitals

Google’s core web vitals geven inzicht in de laadtijd en gebruikservaring van je website. Deze punten zijn onderdeel van de algehele Google web vitals.

Richt je op de core web vitals om zeker te weten dat je website technisch in orde is. Door goed te scoren op deze punten zal Google jouw website niet lager ranken vanwege technische mankementen.

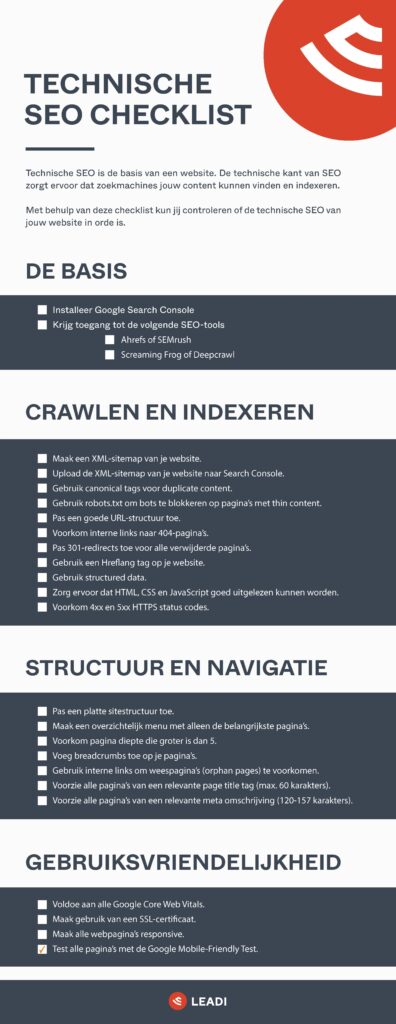

Technische SEO-checklist

Hieronder een checklist om te controleren of jouw technische SEO op orde is. Klik op de afbeelding om naar het PDF-bestand te gaan.

Technische SEO uitbesteden aan Leadi

Technische SEO draait dus volledig om het technische aspect van je website. Een technische SEO campagne is belangrijk om jouw website te kunnen laten ranken in Google. Het is een groot onderdeel waarbij vele verschillende aspecten aan bod komen.

Leadi is een online-marketingbureau en zoekmachine optimalisatie specialist, die zich dus volledig richt op SEO en SEA. Wij hebben een technische SEO-specialist in huis die de technische kant van jouw website volledig kan optimaliseren.

Dit doen we aan de hand van SEO sprints. Sprints zijn korte periodes waarin vooraf bepaalde werkzaamheden worden uitgevoerd. Je zit bij ons dus niet vast aan lange contracten en je betaalt niet voor onnodige zaken of voor het wachten op resultaat.

Met behulp van de analyse sprint keren we je website eerst helemaal binnenstebuiten. Zo kunnen we eventuele problemen en knelpunten identificeren.

Vervolgens kunnen we met behulp van de verbeter sprint al deze knelpunten en problemen oplossen.

Kortom, kan jij wel wat hulp gebruiken met het optimaliseren van je technische SEO? Schroom dan niet om onze hulp in te schakelen. Je kunt via onderstaand formulier vrijblijvend contact met ons opnemen.